Zanim rozpoczynam zajęcia ze studentami na temat pozycjonowania stron internetowych, zawsze zaczynam od podstaw, czyli wyjaśnienia kluczowych trendów, ale i słownictwa. Specjaliści SEO często nie zdają sobie sprawy z tego, że klient po prostu ich nie rozumie. Aby nie wprowadzać niepotrzebnego zamieszania, a także, by mówić wspólnym językiem, zawsze powinniśmy wyjaśnić, czym właściwie jest SEO, a także jakie panują trendy, strategie i zasady.

Dlaczego zrozumienie podstaw SEO jest tak ważne?

Wiele lat temu sama byłam w skórze klienta. Rozpoczynałam wówczas swoją działalność i na temat pozycjonowania stron nie wiedziałam nic więcej, prócz tego, że jest i ma zapewnić widoczność mojej firmy w Internecie. W jaki sposób? Nie miałam pojęcia, a język, w jakim mówili do mnie specjaliści SEO, był kompletnie niezrozumiały.

To był też czas, kiedy zaczęłam interesować się pozycjonowaniem stron, kończyć kursy i szkolenia, po to, aby zrozumieć, jak to działa. Niestety agencje, z którymi współpracowałam, nie poświęciły mi czasu, bym mogła zrozumieć, co robią, a także co powinnam robić ja, by moje działania przyniosły efekty.

Z perspektywy czasu cieszę się, że tego nie zrobili, bo ja nie rozpoczęłabym moich wnikliwych poszukiwań odpowiedzi i nie ukończyłabym kursów SEO. Na dodatek, nie dowiedziałabym się, jak niektóre agencje przeinaczają fakty, by ich praca wydała się bardziej efektywna niż w rzeczywistości jest.

Zrozumienie podstaw SEO, a także kluczowych zasad, trendów i terminów, pozwoli nam na lepsze zrozumienie, współpracę bądź po prostu na uniknięcie nieporozumień z nieuczciwym „specjalistą” SEO.

Podstawy SEO

O roli SEO (pozycjonowanie stron) wie każdy, kto posiada własną witrynę i komu zależy, by znalazła się ona wysoko w wyszukiwarce. Coraz częściej mam do czynienia z ludźmi, którzy wydają się ekspertami z zakresu pozycjonowania stron, nie znając podstawowych terminów. Jeśli jesteś ciekaw, czy znasz kluczowe zagadnienia z omawianego zakresu, sprawdź, czy poniższe terminy i strategie SEO nie są Ci obce.

Czym właściwie jest SEO i pozycjonowanie stron?

SEO (ang. Search Engine Optimalization) jest to optymalizacja treści znajdujących się na stronach internetowych pod kątem wyszukiwarek. Proces ten ma na celu zapewnienie jak najwyższej pozycji witrynie na wybrane słowa i wyrażenia kluczowe.

W Polsce mówimy najczęściej o pozycjonowaniu stron w wyszukiwarce Google, ponieważ to ona dominuje na rynku, zagarniając 97% ruchu. Kolejne to Bing i Yahoo! z niespełna dwuprocentowym wynikiem. Należy jednak pamiętać, że Google nie dominuje na całym świecie. Najpopularniejszą wyszukiwarką w Rosji jest Yandex (52%), a w Chinach — Baidu (60%) i Haosou (30%).

Aby zrozumieć działania pozycjonerów, należy poznać sposób, w jaki działają wyszukiwarki. Wszystkie strony internetowe są „odwiedzane” przez boty, które przeszukują strony internetowe, analizując ich treść i zawartość. Następnie je indeksują — co oznacza, że strony te stają się widoczne i możliwe do znalezienia w Internecie. Nadawana jest im także określona wartość i to właśnie ona decyduje, czy strona internetowa znajdzie się na samej górze listy wyszukiwań.

A jak zadbać o wartość naszej strony? Na to wpływa wiele czynników, których celem jest zapewnienie jak najwyższej jakości i użyteczności witryny z punktu widzenia Internautów.

Uzyskana pozycja zależna jest od wielu zmiennych. Między innymi od aktualnych zmian w algorytmach (ponad 200 czynników), ale i konkurencyjności w branży.

Czynniki, które wpływają na pozycje strony internetowej, możemy podzielić na te, które realizowane są bezpośrednio na niej (on-site SEO) i są to na przykład prawidłowo opracowane treści oraz te, które realizowane są poza nią (off-site SEO).

Strategie on-site SEO

Strategie on-site dotyczą między innymi treści, które zamieszczone są na stronie internetowej. Oznacza to, że witryna powinna posiadać unikalne treści, które opracowane są zgodnie z zasadami webwritingu, a także z zasadami SEO (na przykład powinna być zachowana gęstość słów kluczowych). Strona powinna również być dostępna dla robotów wyszukiwarek, posiadać odpowiednią strukturę adresów URL, odpowiednie linkowania wewnętrzne, nagłówki, opisy grafik i tak dalej. O strategiach on-site SEO na pewno jeszcze napiszę, aby przybliżyć Wam, co możecie sami zrobić w obrębie swojej witryny internetowej, by podnieść jej widoczność w sieci.

Strategia off-site SEO

Strategia off-site SEO dotyczy wszelkich działań, których celem jest podniesienie widoczności witryny w Internecie, a które realizowane są poza nią. Oznacza to na przykład linkowanie do katalogów zewnętrznych, wymianę linków między stronami, a także wszelkie działania, które mają na celu zamieszczenia linków do naszej strony na innych, wartościowych i dobrych jakościowo witrynach.

SEM

To inaczej marketing w wyszukiwarkach (Search Engine Marketing). SEM obejmuje wszystkie działania, które realizowane są za pośrednictwem wyszukiwarki takie jak pozycjonowanie stron i linki sponsorowane. Są to więc zarówno działania płatne, jak i bezpłatne, których celem zapewnienie witrynie jak najlepszej pozycji w Internecie.

SERP

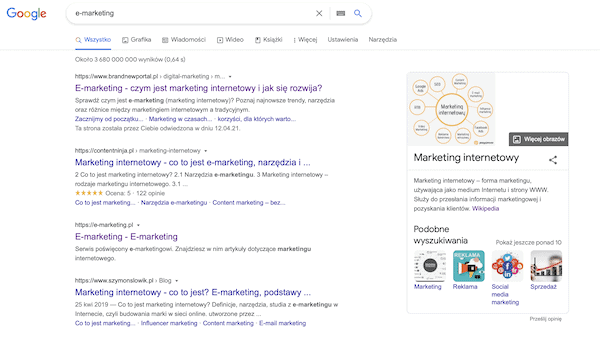

SERP (ang. search engine result page) to inaczej strona z wynikami wyszukiwania. Znajdziemy tutaj zarówno bezpłatne, jak i płatne wyniki wyszukiwania (organiczne i nieorganiczne). Obecnie w zależności od zapytania, w SERP-ie mogą pojawić się także:

- wizytówki Google Moja Firma,

- szybkie odpowiedzi (tak zwane Direct Answers),

- mapki Google,

- podpowiedzi Zero Click Search Results,

- podpowiedzi Google.

- Direct Answers

Direct Answers

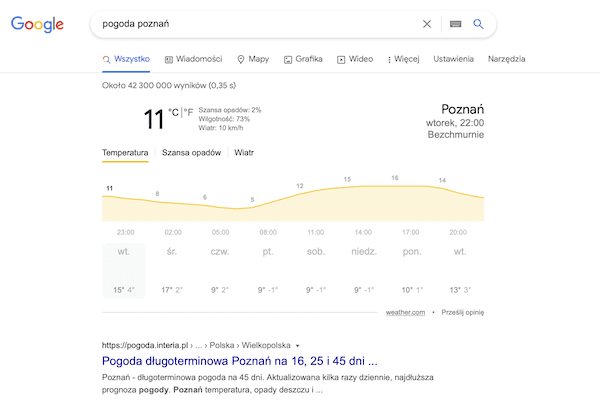

Direct Answers to tak zwane szybkie odpowiedzi. Jest to dodatkowy element zaproponowany przez Google, który ma podnieść użyteczność wyszukiwarki dla Internautów. Ich celem jest dostarczenie użytkownikom szybkiej i precyzyjnej odpowiedzi na zadane pytanie, bezpośrednio w SERP-ie, bez potrzeby przechodzenia do strony internetowej, która jest źródłem informacji. Przykładami Direct Answers są:

- tłumacz Google (Google Translate),

- zdjęcia,

- zakupy Google (Google Shopping),

- Video,

- Wiadomości (Google News),

- kalkulator,

- rezerwacja lotów Google (Google Flights),

- rezerwacja hoteli,

- prognoza pogody,

- przelicznik walut,

- przelicznik jednostek,

- czas na świecie.

Zero Click Search Results (Featured Snipped)

Coraz częściej można odnieść wrażenie, że Google stara się zatrzymać użytkowników w swojej wyszukiwarce. Podobnym rozwiązaniem do Direct Answers jest również tak zwany Featured Snipped — Zero Click Search Reasult, czy po prostu wynik 0 w wyszukiwarce.

Mamy do czynienia z tym rozwiązaniem wówczas, gdy użytkownik poszukuje odpowiedzi na swoje pytanie i uzyskuje ją bezpośrednio na w SERP-ie. Co prawda, widzi wyłącznie jej fragment, ale najczęściej nie czuje już potrzeby przechodzenia na stronę internetową. Featured Snipped znajduje się na samej górze listy wyszukiwań. Dla pozycjonerów stanowi to w pewnym sensie problem, ponieważ z jednej strony jako wynik 0 przedstawione są te fragmenty, które zdaniem Google są najbardziej wartościowe, jednak według badań ludzie, widząc odpowiedź na poziomie wyszukiwarki, nie przechodzą dalej. A w ten sam sposób pozycjonerzy nie realizują swojego celu, czyli nie przekierowują ruchu organicznego na stronę internetową.

Szacuje się, że obecnie ponad 50% zapytań posiada swój wynik 0. Moim zdaniem stanowi to zagrożenie dla pozycjonowania stron, które znamy.

White Hat SEO (WHS)

White Hat SEO to inaczej etyczne praktyki SEO, które realizowane są zgodnie z wytycznymi wyszukiwarek. Bazują one na rozbudowie treści w witrynie i poprawie jej użyteczności, w ten sposób, by przynosiła możliwie wysoką wartość dla użytkowników Internetu. Wśród praktyk White Hat SEO wymienia się między innymi:

- unikalny, dobry jakościowo content,

- odpowiednia struktura treści (nagłówki, tytuły, śródtytuły, słowa kluczowe),

- czytelna mapa serwisu,

- właściwa struktura linków,

- bezpieczeństwo witryny,

- szybkość i prawidłowość działania.

Black Hat SEO (BHS)

Black Hat SEO to inaczej nieetyczne praktyki SEO realizowane w wyszukiwarce, których celem jest szybkie pozycjonowanie strony internetowej w sposób niezgodny z zasadami Google. Sztuczne sposoby przyśpieszające proces pozycjonowania mogą doprowadzić do usunięcia strony z wyników wyszukiwania (usunięcie z indeksu) lub ograniczenie widoczności (filtry).

Wśród najczęstszych taktyk Black Hat SEO wymienia się między innymi:

- ukrywanie elementów strony poprzez wykorzystywanie tego samego koloru zarówno czcionki, jak i tła,

- systemy wymiany linków,

- precle — oznaczające strony, których jedynym celem jest umieszczanie na nich linków pozwalających na pozycjonowanie stron.

Plik robots.txt

Pliki robots.txt są jednym z mechanizmów o nazwie Robots Exclusion Protocol, których celem jest informowanie automatów o tym, czego nie powinny robić w obszarze danej witryny. Z taką sytuacją mamy do czynienia w momencie, kiedy właściciele stron nie chcą, by strona była dostępna w wyszukiwarkach. Wówczas wystarczy umieścić plik robots.txt w katalogu głównym danej domeny.

Świeżo zamieszczane materiały w Internecie są wyszukiwane przez tak zwane roboty (boty). Podążają one za hiperłączami i dokonują indeksacji pełnej zawartości witryny. Roboty analizują całą stronę wraz z jej strukturą, by dodać nowe informacje do wyszukiwarki. Pozycja WWW w wyszukiwarce zależy wówczas od jej zgodności z algorytmem. Spod indeksowania można wyłączyć nie tylko całą witrynę, ale również jej poszczególne katalogi czy zdjęcia.

Plik robots.txt można stworzyć, korzystając z najprostszego edytora tekstowego lub managerów FTP.

Mapa strony

Mapa strony (ang. sitemap) to plik, w którym zamieszczone są strony danej witryny. Dzięki mapie wyszukiwarki otrzymują informacje o formie uporządkowania treści. Mapa strony pozwala na skuteczniejsze indeksowanie witryny przez roboty.

Plik nie jest obowiązkowy, jednak jest wskazany, w szczególności, jeśli mamy do czynienia z obszerną stroną. Przy wielu podstronach, może się zdarzyć, że boty nie znajdą, a zarazem nie zaindeksują wszystkich. Warto pomyśleć o mapie w przypadku nowych stron, do których nie prowadzi zbyt wiele linków zewnętrznych, gdyż boty indeksują, śledząc linkowania między stronami.

Nofollow i Dofollow

Nofollow i dofollow są to znaczniki, które pełnią ważną funkcję w procesie pozycjonowania stron. Szczególne znaczenie mają dla botów indeksujących. Dzięki nim roboty wiedzą, czy należy podążać za danym linkiem, a tym samym przekazać część mocy strony internetowej, czy wręcz odwrotnie – nie podążać, gdyż zaznaczono, że dany link nie ma większego znaczenia.

Dofollow wskazuje robotom indeksującym, że powinny podążać do linkowanej strony. Oznacza to, że dana witryna jest znacząca i ważna w oczach wyszukiwarki, a tym samym przekazuje jej część mocy z witryny, w której osadzony jest link.

Linki z atrybutem Nofollow wskazują, że roboty indeksujące nie muszą kierować się do danej witryny, gdyż nie ma ona dużego znaczenia.

Reasumując, z punktu widzenia pozycjonera, znacznie ważniejsze jest, by zdobywać linki typu Dofollow, które podnoszą wartość witryny.

Przekierowanie 301

Przekierowanie 301 ma znaczenie dla botów, gdyż wskazuje, że poszukiwane dane są dostępne w innym miejscu. Rozwiązanie wykorzystywane jest, na przykład w przypadku, gdy witryna funkcjonuje pod dwoma adresami, np. www.brandnewportal.dfirma.pl i brandnewportal.dfirma.pl.

Dla robotów wyszukiwarek są to dwie różne strony. Korzystając z przekierowania 301 dajemy znać, że jeden z tych adresów jest nadrzędny i to do niego powinien być przekierowany ruch. Przykrą konsekwencją niekorzystania z przekierowania 301 jest kara od wyszukiwarek za duplicate content.

Przekierowanie 301 wykorzystywane jest także do przekazania mocy ze starej witryny do nowej.

Kanonizacja

Rel=canonical pozwala uniknąć zjawiska o nazwie duplicate content, czyli duplikacji treści zamieszczonej w danej witrynie. Dzięki wykorzystaniu canonicala, masz możliwość zastosowania istniejących treści, które są już dostępne na innych stronach, a roboty indeksujące nie obciążą Cię karą za powielanie treści. Korzystając z tagu, wskazujemy robotom, która treść jest oryginalna, a której nie powinien indeksować.

Jeśli znałeś wszystkie powyższe definicje, strategie i podstawy SEO, to gratuluję. Widocznie znasz fundamenty pozycjonowania stron i stosujesz je w swojej witrynie. Pamiętaj jednak, że SEO jest bardzo szeroką dziedziną i aby skutecznie zarządzać pozycją w wyszukiwarce, należy być na bieżąco i poznawać nowe trendy oraz wymagania stawiane przez algorytmy.